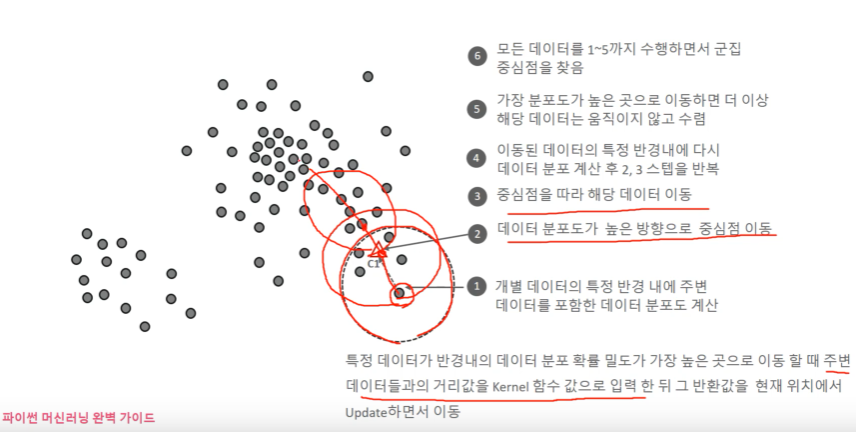

KED(kernel Density Estimation)을 이용하여 데이터 포인트들이 데이터 분포가 높은 곳으로 이동하면서 군집화를 수행. 군집화 개수를 지정하지 않고, 데이터 분포도에 기반하여 자동으로 군집화 개수를 정함. KDE는 커널함수를 통해 어떤 변수의 확률밀도 함수를 추정하는 방식. 관측된 데이터 각각에 커널 함수를 적용한 값을 모두 더한뒤 데이터 건수로 나누어서 확률 밀도 함수를 추정. 확률 밀도 추정 방법 1. 데이터가 특정 데이터 분포를 따른다는 가정하에 데이터 분포를 찾는 방법. Gaussian Mixture 등이 있음. 2. 데이터가 특정 분포를 따르지 않는다는 가정하에 밀도를 추정. KDE KDE bandwidth h가 작으면 가우시안 분포 그래프에서 폭이 좁아짐. mean shift..